Acabo de leer un

artículo de Yarkoni y Westfall en el que la pregunta es si la

psicología va por buen camino al insistir en explicar y minimizar la relevancia de predecir. La apuesta de los autores es clara: hay que orientarse a

la segunda porque la primera saldrá beneficiada y, además, se combatirán eficazmente

los problemas de replicabilidad que últimamente han llegado a obsesionar dentro

y fuera de la Psicología.

Al terminar el manuscrito tuve una

desagradable sensación. Rebuscando en el bosque de mi memoria encontré una de las causas: una oceánica

ignorancia histórica de parte de Yarkoni y Westfall. Albergo la esperanza de que sea ignorancia

y no negligencia o selectividad.

Lee J.

Cronbach,

el psicólogo que hizo un enorme esfuerzo por combinar las conocidas como dos

tradiciones o disciplinas de la psicología científica (experimental y

correlacional), incluso al tomar posesión de la presidencia de la American Psychological Association

(APA), se omite aquí. Al menos se le podría haber rendido un pequeño

homenaje para enmarcar el problema, que dista de ser nuevo.

Los autores exponen una serie de

ejemplos sobre esas dos perspectivas, la basada en la explicación y en la

predicción. Ninguna se salva de la quema, en realidad, porque lo que ellos

desean es convencer a la comunidad de que lo que va a misa es el ‘machine learning’ (ML). Evitan, una vez

más, recurrir a ejemplos que disminuirían el efecto aplastante que pretenden

darle a su aproximación (lo que huele un pelín a selectividad –no es p-hacking, pero se acerca). No repetiré

aquí –aunque me tienta mogollón—eso que Pinker reconoció hace unos meses en Twitter sobre el robusto carácter del estudio

de la inteligencia humana.

Hay que reconocer que el artículo

detalla con claridad los conceptos de sobreajuste (overfitting), validación cruzada (cross-validation) y regularización. La obsesión por las

explicaciones mecanicistas (causales) en Psicología está detrás de la crisis de

replicabilidad. El p-hacking y una

práctica que hasta me han confesado los psicólogos experimentales de mi Facultad

–ir mirando si el efecto sale y dejar de recoger datos cuando la cosa casa—que

también se denuncia aquí, causa –esta vez si—los problemas.

Los métodos de ML pueden acabar con

nuestros dolores de cabeza, según Tal Yarkoni y su colega. Si somos capaces de

generar un modelo predictivo estudiando un grupo de individuos y comprobar que

funciona en un grupo independiente, habremos triunfado. La meta del ML es

pronosticar futuras observaciones del modo más preciso posible, lo que supone

minimizar el error (la obsesión de los psicómetras –como explica

de modo hilarante D. K. Detterman).

Pero alcanzar esa meta exige al menos

tres cosas:

1) Usar bases de datos con numerosos

casos para disponer de información con la que ‘entrenar’ al modelo que luego se

usará de cara a la predicción.

2) Estimar con precisión el nivel de

error para valorar adecuadamente el modelo y averiguar si puede mejorarse

(validación cruzada).

3) Manipular el balance sesgo-varianza

(que no voy a explicar porque es chungo, pero que tiene que ver con la

regularización).

Una de las consecuencias de usar

bases de datos con muchos casos es que los efectos que pensamos eran grandes se

reducen, a menudo dramáticamente. Un caso claro es la genética

molecular. Se preguntan los autores si vale la pena gastarse los cuartos en

hacer estudios a pequeña escala. Favorecen una respuesta negativa, puesto que

existen actualmente enormes

bases de datos públicas que no se están utilizando.

Subrayan la importancia de la

validación cruzada para estimar el error en la predicción. La idea es

‘entrenar’ un modelo usando una base de datos y ‘probarlo’ usando una base de

datos independiente, aunque sean del mismo pool registrado. Es claramente más eficiente que la replicación porque no

se requiere recoger nuevos datos. La conocida como K-fold cross-validation

es particularmente potente porque pueden usarse todos los casos de la base de

datos para entrenar y probar el modelo (leave-one-out

cross-validation).

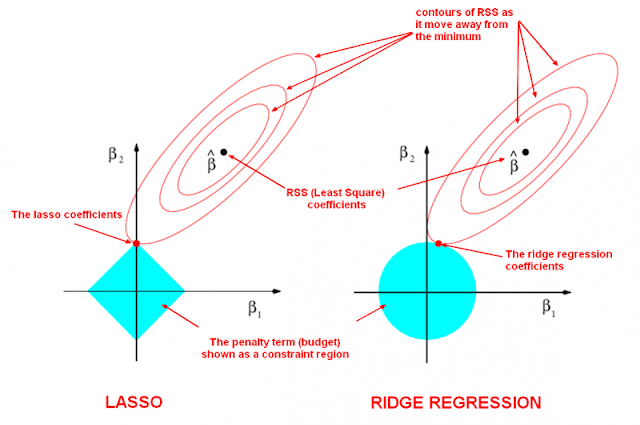

La regularización también es

importante porque prima la parsimonia. Es posible que un modelo más complejo

atesore mayor capacidad predictiva, pero hay que considerar la relación coste-beneficio.

Un método útil para alcanzar ese objetivo es el LASSO (Least Absolute Shrinkage and Selection Operator). Es decir, se

trata de responder la pregunta de si añadir un determinado predictor nos hace

ganar realmente capacidad predictiva.

En resumen, Yarkoni y Westfall

concluyen que la psicología “ganará mucho relajando su énfasis por descubrir los

mecanismos causales que gobiernan la conducta y orientándose en mayor grado

hacia la precisión predictiva (…) los método de ML deben contemplarse como una

oportunidad, no como una amenaza”.

Soy psicólogo y trabajo actualmente en un departamento de análisis economico de una gran financiera (cosas raras veredes amigo Sancho). Puedo asegurar que los métodos de Machine Learning han revolucionado el modo en que se hacen las cosas en mi trabajo. La predicción aplicada a Procesamiento de Lenguaje Natural para tomar decisiónes es cosa diaria y no me disgusta el planteamiento de Yarkoni y Westfall.

ResponderEliminarHola psicólogo. No tengo nada en contra del ML. Al contrario. Solamente me molestó el enfoque con el que se presenta esta historia en su artículo. Pero es algo claramente menor e irrelevante. Saludos, R

ResponderEliminarSin duda, para la psicologia aplicada: la predicción, pero para los académicos e investigadores de la Psicologia eso es poco... como en todas las ciencias....

ResponderEliminarGracias Antonio. Nuestro querido R. B. Cattell le dio bastantes vueltas a esta cuestión de la predicción y la explicación. La memoria de los científicos es frágil y a menudo somos un poco perezosos al revisar a los clásicos. Es muy recomendable: Cattell, R. B., 1988. Psychological testing and scientific method. In J. R. Nesselroade & R. B. Cattell, Eds., Handbook of Multivariate Experimental Psychology. New York, Plenum Press.

ResponderEliminar